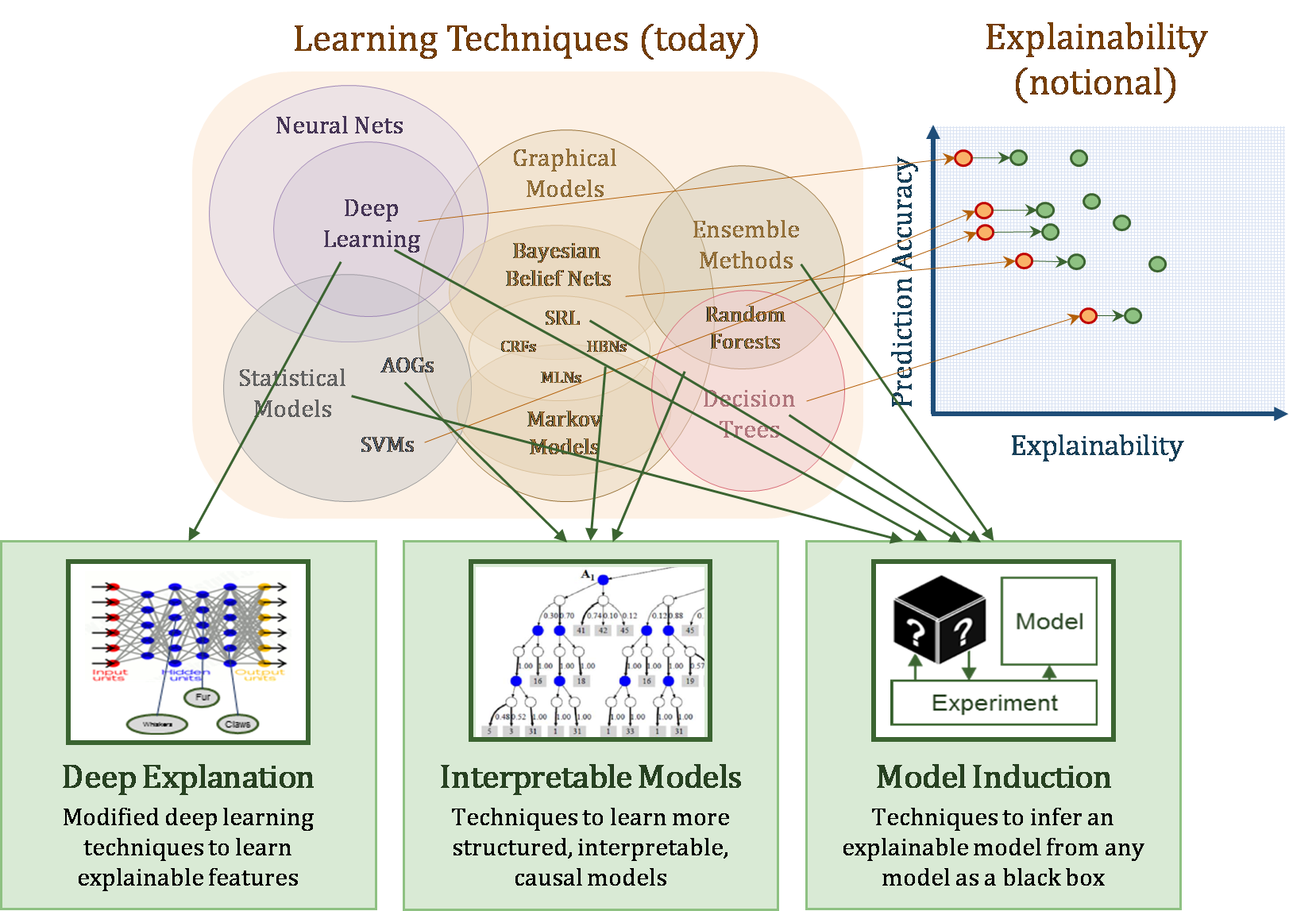

資料來源:"Explainable Artificial Intelligence (XAI)"

近年來由於深度神經網路模型的突破,加上電腦計算能力不斷地提高,使得產業界再度重視類神經網路,也因此催生了大規模且效果顯著的應用案例,以及對應的學術研究課題,其中,困擾了類神經網路數十年來的黑盒子問題,也重新受到檢視。深度神經網路隱藏層之間相連權重的計算往往經過線性與非線性的轉換,即便給定一個訓練良好的深度神經網路,能在輸出層得到一穩定且準確的預判,但對整個模型的推理過程往往不得而知,故常被稱為黑盒子運作,無法建立輸入層與輸出預測值之間的關聯,將使模型的可信度與被採用度大大降低。如上圖所示,美國國防高等研究計劃署在2016年時啟動了一基礎研究計畫,旨在探究深度神經網路模型的分類與其可解釋性。儘管深度學習模型在近年來取得亮眼表現,但在許多應用場景中,輸入層的變數對使用者具有確切的物理意義與解釋能力,回溯至輸入層並揪出重要因素至關重要。在特定產業,如製造業良率分析、製程偵錯上,其應用仍受質疑。因此,拆解已經訓練完成的深度學習模型,發展出一套對應的解析框架,套用到不同架構的類神經網路模型上,將其黑盒子中的推理邏輯給判斷出來,提升產業採行深度神經網路技術的信心,XAI可視為平行於發展高精度深度神經模型的重要任務。